Con las numerosas alusiones a los "big data" y los sofisticados métodos de análisis que requieren también se está hablando cada vez más de la inteligencia artificial, que es uno de los recursos que utilizan las grandes empresas como Google, Facebook y Microsoft. Quizá el caso más sonado fue la red compuesta por mas de 16.000 nodos (procesadores) creada por Google en 2012 con la que consiguieron que, tras revisar más de 10 millones de imágenes presentes en vídeos de YouTube, ésta pudiese por si misma aprender a reconocer un gato (Actualidad Gadget, 2/06/2015). Esta hazaña se consiguió al "enseñar" a un ordenador a reconocer una entidad utilizando lo que se denomina "aprendizaje profundo". El sistema ha avanzado y permite ya reconocer objetos en las fotografías, aunque los resultados no son siempre lo que se podría esperar, especialmente si las imágenes originales son confusas o tienen mucho "ruido", como muestran las siguientes imágenes "extraídas" por el sistema. Ha significado incluso un bochorno para Google al etiquetar a dos afroamericanos como monos (Genbeta, 1/07/2015)

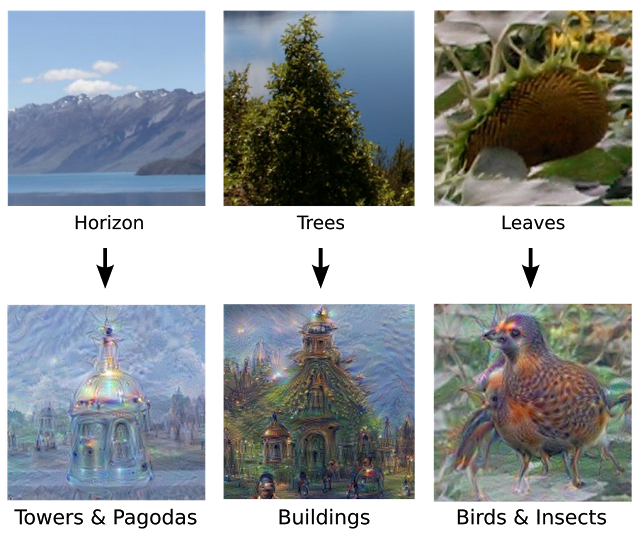

Lo que Google ha hecho es lo que llaman «incepcionismo»: resaltar sobre una imagen convencional las diferencias y detalles que el software reconoce de forma más acusada. De este modo logramos ver algo así como «lo que llama la atención a la inteligencia artificial», algo que normalmente no se ve pero que está dando vueltas por los circuitos de memoria. (FayerWayer, 19/06/2015).

Wolfram también puso este tipo de sistema a disposición de todos a través una página web. Se supone que es capaz de identificar (en texto) el contenido de las imágenes subidas por el usuario, pero las pruebas solo funcionan con imágenes simples como una flor o un edificio. Mi foto de una estación de metro fue identificada como "shopping center".

Facebook, que también trabaja en el mismo tipo de proyecto de IA, ha presentado un estudio en el que explica cómo han creado un sistema capaz de aprender por sí sólo y crear sin ayuda externa imágenes de un tamaño de 64 por 64 píxeles tal que el 40% de los voluntarios que las han visualizado llegaron a pensar que eran reales (Imagen siguiente). (Genbeta, 22/06/2015)

Otras aplicaciones han tenido un éxito suficiente incluso para poner "robots" a redactar noticias. Ya en 2012 se instaló un "robot periodista" en Forbes y el Los Angeles Times empezó a utilizar algoritmos en marzo de 2014 para traspasar datos a plantillas que les dan formato de notas de prwnsa (ABC.es, 20/03/2014). El tema de los "robots periodistas" también fue tratado en el GEN Summit, la cumbre mundial de los editores de medios de comunicación (ElDiario.es, 16/06/2014). El sistema de "aprendizaje profundo" DeepMind, de Google, también ha logrado con éxito "leer" y resumir textos tomados del Daily Mail y de CNN. Incluso es capaz de responder el 60% de las preguntas simple acerca de los textos (Technology Review, 17/06/2015). En esta dirección ha aparecido Quill, una tecnología capaz de convertir datos en una historia escrita. El algoritmo es suficientemente "inteligente" para redactar textos o interpretar las visualizaciones de datos, y podría convertirse en el rival de los científicos de datos (TICbeat, 2/02/2015 ).

El aprendizaje automático se utiliza cada vez más, especialmente en las empresas más grandes -y especialmente las redes sociales- que invierten en laboratorios de inteligencia artificial, muchas veces comprando empresas pequeñas pero más avanzadas. Así, por ejemplo, Twitter hizo pública la adquisición de la compañía Whetlab, especializada en inteligencia artificial y machine learning. Pero ésto puede tener, al menos por un tiempo, una consecuencia nefasta para los demás utilizadores: las empresas adquiridas dejan de ofrecer sus servicios a terceros, retrasando el desarrollo de aplicaciones de uso más masivo.

El aprendizaje automático y otras "soluciones" de inteligencia artificial plantean otro problema. Cuando pedimos a un especialista la solución para algún problema, esperamos que justifique de algún modo su respuesta. Con los actuales sistemas de IA, ésto sería imposible: ofrecen resultados, pero sin poder mostrar el "camino" recorrido para llegar a ellos. Los creadores de estas aplicaciones nos piden un "acto de fe", algo bastante inusual en el mundo científico, como hizo notar Steve Lohr en un artículo para The New York Times (6/04/2015). IBM ha intentando paliar este problema con "Watson Paths", que ofrece una visualización del árbol de decisión seguido por este supercomputador. Pero el experto en IA, Danny Hillis, comenta en el mismo artículo que no es suficiente (requiere aún una interpretación) y que la única solución satisfactoria sería producir un relato ("story telling") describiendo cómo se llega a la conclusión ofrecida. Exponer el razonamiento facilita la comprensión, la aceptación (o refutación) y el aprendizaje humano.

Utilizar ciegamente el aprendizaje de máquina para el análisis de Big Data y, con ello, tomar decisiones basadas en predicciones artificiales como se está haciendo podría ser muy riesgoso. Las empresas que ofrecen estos sistemas o los servicios asociados nos piden que confiemos ciegamente en los algoritmos creados por sus ingenieros pero no nos dan, hoy, ninguna prueba de que son realmente confiables y no nos permiten, lamentablemente, comprender los resultados que entregan.

Dos grupos de investigadores de las Universidades de Harvard y Washington acaban de demostrar que algunos algoritmos diseñados por empresas punteras como Google o Microsoft, son discriminatorios. Los de Washington lanzaron una búsqueda de imágenes en Google introduciendo el término «CEO» en el ámbito de Estados Unidos, obteniendo como resultado que solo en el 11% de las imágenes aparecen mujeres. Sin embargo, la realidad es que el 27% de los directores generales de las empresas estadounidenses son mujeres. Los de Harvard hicieron búsquedas con nombres de pila y, al introducir un nombre como Jermaine o Darnell, habituales en personas negras, obtuvieron que la palabra «detención» aparecía en entre el 81 y el 95% de las entradas. Y esta misma búsqueda pero con nombres como Emma o Geoffrey, que suelen identificar a personas blancas mayoritariamente, devolvía unos porcentajes que van del 23 al 60%. (Xataka, 10/807/2015).

¿Qué pasaría si un gobierno tomase decisiones de política social o en las "ciudades inteligentes" basado en algoritmos erróneos como éstos? ¡Peor aún si un médico decide un tratamiento basado en un diagnóstico erróneo, por confiar en un programa de IA! Steve Lohr indica un camino que la "ciencia de datos" debe recorrer a toda costa antes de ser realmente confiable: "Estas preguntas están estimulando una rama de estudio académico conocida como rendición de cuentas algorítmica (algorithmic accountability)". (ComputerWorld, 19/06/2015)

Pero, pero... ni Siri ni Deep Blue ni los mejores software son capaces de superar y mejorar a la inteligencia humana. Solo ejecutan algunas tareas mejor o más rápido que nosotros. ¿Necesitamos realmente máquinas con "superinteligencia? Algunos científicos (Stephen Hawking y Elon Musk entre otros) lo consideran peligroso mientras otros (como Bill Gates y Mark Zuckerberg) invierten en su desarrollo. (Elon Musk, fundador de Tesla y SpaceX, donó 10 millones de dólares a la fundación Future of Life Institute, una institución que trabaja e investiga para mantener el enfoque benefactor de la Inteligencia Artificial*). Ésto plantea más de un dilema ético junto con el científico: ¿Cómo debería ser? ¿Podría llegar a ser tan superior que acabe eliminando a los humanos por nuestra incapacidad de manejarlas (como plantea Nick Bostrom)? (Gizmodo, 3/07/2015).

Google, Microsoft y Facebook, entre otros, firmaron en el pasado mes de enero un manifiesto que pretendía ser una especie de manual de buenas prácticas en todo lo que tiene que ver con la IA (Xataka, 4/07/2015).

* Los 37 grupos de investigación ganadores del programa del aporte de Musk al Future of Life Institute.

No hay comentarios:

Publicar un comentario

No se reciben comentarios.

Nota: solo los miembros de este blog pueden publicar comentarios.