Internet

Según Genbeta, "el 2016 ha sido un año no demasiado bueno para Internet. Las noticias falsas y el acoso online han tomado las redes sociales, los gobiernos y empresas reaccionan recortando libertades y privacidad, y mientras, se ha iniciado una nueva era de ataques online a través de botnets". También mencionan los hackeos masivos y las grandes filtraciones que siguieron. "También ha sido un año especialmente malo para nuestra privacidad", las grandes plataformas recopilando más y más datos. (Genbeta, 9/12/2016)

"Google conoce exactamente lo que le interesa a sus usuarios Eso ha quedado totalmente demostrado con la publicación de sus búsquedas más populares durante 2016. Se trata de un hecho que no tiene muy contentos a los grupos de defensa de los derechos de los consumidores como Consumer Watchdog y The Privacy Rights Clearinghouse, quienes han solicitado la intervención de las autoridades para regular las prácticas de la compañía." (FayerWayer, 21/12/2016)

La "nube" no ha tenido la penetración que se esperaba, según John Dvorak, en parte por el abaratamiento de los discos duros (us$99 por 1TB) (PC Magazine, 28/12/2016).

Wikipedia: "Donald Trump" y "Las muertes en 2016" fueron las páginas más editadas (@cdperiodismo, 23/12/2016).

Todo el año se ha promocionado el "análisis de big data" como un recurso indispensable para las empresas (ComputerWorld, 21/12/2016). Cierto es que deben conocer lo mejor posible sus clientes, pero también se ha advertido el peligro de confiar mucho en los algoritmos y la necesidad de contar con buenos -y aún escasos- "científicos de datos".

Software

Según TICbeat (29/12/2016), la mensajería instantánea y la inteligencia artificial han experimentado fructíferos avances este año. "Tanto es así que hoy vivimos una auténtica revolución en el campo de la atención al cliente en tiempo real, cada vez más personalizada y exacta.[...] Las marcas que impulsan estos canales de mensajería para comunicarse con sus clientes experimentan un crecimiento neto en el número de interacciones en todos los canales porque los usuarios están más incentivados y han migrado su conducta hacia el uso de las nuevas soluciones tecnológicas."

La inteligencia artificial amenaza de 2 a 3 millones de empleos en el sector transporte de EEUU conforme se desarrolle la conducción autónoma, según informe publicado por la Casa Blanca. (TICbeat, 24712/2016)

En materia de app, lo más notable fue el furor causado por Pokémon Go. Se destaca también PhotoScan, de Google, para escanear fotos en papel. (ElPaís.com, 22/12/2016)

Seguridad

El 2016 pasará a la historia como el año de la gran explosión del ransomware (una forma de extorsión digital que permite que los atacantes que encripten los archivos del ordenador para después pedir un rescate) (TICbeat, 26/12/2016). Es un problema cada vez más presente en todo el mundo, que generó en el año más de 1.000 millones para los delincuentes (Wwwhat's New, 19/12/2016).

Bruce Schneier, uno de los expertos en seguridad más respetados, ha declarado que ha quedado claro que Yahoo no ha tomado en serio la seguridad desde hace tiempo (se conoce desde hace unos 10 años la debilidad del método que usa) y que "tendría dificultad en seguir confiando en Yahoo" (The Guardian, 15/12/2016).

Los ciberataques masivos (como el que afectó Yahoo) también han llamado la atención sobre la poca seguridad en la internet de las cosas (PC Actual, 20/12/2016).

Móviles y redes

Según Global Web Index, ocho de cada diez usuarios prefieren smartphones para navegar en redes sociales (26/11/2016) sin embargo "las redes sociales han perdido parte de su encanto". [En varios países] empiezan a cansarse de las fotografías y momentos de felicidad de Facebook, los grupos de WhatsApp y el “always on” 24/7 (TICbeat, 20/12/2016).

La investigación realizada por Ipsos, comScore y Nielsen, señala que YouTube llega a más gente en el móvil que cualquier cadena de televisión abierta o de cable.(@periodismo, 27/12/2016).

Más de la mitad de los 3.400 millones de personas con acceso a Internet acceden a Facebook cada mes. Los ingresos de esta plataforma en los primeros nueve meses de 2016 subieron un 36 por ciento, a 19.000 millones de dólares mientras su beneficio casi se triplicó, a us$ 6 mil millones (MIT Technology Review). Zuckerberg reconoció finalmente que su compañía era "tecnológica y de comunicación" (ElMundo.es, 22/12/2016).

Y aunque Facebook parece ser uno de los medios favoritos para acceder a las noticias, un estudio de Chartbeat - que analizó más de 700 medios de comunicación y 70 millones de URLs únicas accedidas a través de Google, Facebook y Twitter - mostró que las noticias de último minuto pueden nacer y extenderse rápidamente en redes sociales, pero los usuarios prefieren leer medios reconocidos por su marca para dar seguimiento a estos acontecimientos noticiosos (@periodismo, 27/12/2016; gráfico original a continuación).

En 2016, las noticias de los medios se enfrentaron con una corriente producida por falsificadores. La elección norteamericana inspiró más "tribalismo" en línea, y la confianza de los ciudadanos en los medios de comunicación tradicionales se redujo allá a su nivel más bajo: según Gallup, sólo el 32 por ciento dijo que tenía confianza en los medios de comunicación (Wired, 26/12/2016). Incluso el presidente de la UE llamó a actuar con firmeza para detener las noticias falsas en la red (FauerIre, 26/12/2016)

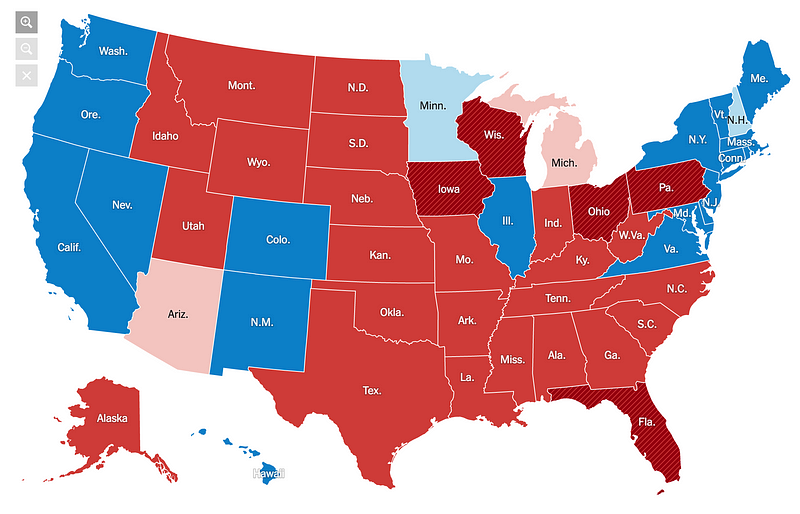

El amplio uso de los smartphones está teniendo influencia en la disciplina infográfica: obliga a diseños más compactos, con un especial esfuerzo de claridad y de ir a lo esencial, como remarcó Nathan Yau en FlowingData (29/12/2016). De su selección, elegí el gráfico adjunto, de The Wall Street Journal, sobre la evolución de los resultados de las elecciones norteamericanas.

eComercio

Hardware

Los fracasos tecnológicos más sonados en 2016: el «explosivo» Samsung Galaxy Note 7; los vehículos eléctricos de Tesla que sufrieron algunos accidentes; el dronque GoPro tuvo que retirar del mercado; las ventas de relojes "inteligentes" que cayeron en picada y varias empresas han abandonado su producción (ABC.es, 12/12/2016). Las pocas ventas ponen en duda la necesidad (y utilidad) de estos relojes. Pebble ha tirado definitivamente la toalla y ha vendido sus activos a Fitbit, que no seguiría produciéndolos. Muchos fabricantes, como Motorola, también reducen o abandonan la producción y muchos analistas creen que la caída en el número de unidades vendidas por Apple podría ya superar el 70%. (PC Actual, 20/12/2016)

Para Apple, el iPhone 7 no tuvo el resultado esperado y también enfrenta críticas para el iPhone 6S y el nuevo Mac Pro. Y si se esperaba que 2016 fuese el año de la realidad virtual, los resultados tampoco son auspiciosos debido en parte al alto precio de los lentes y las "experiencias imperfectas" de los usuarios. (ElMundo.es, 24/12/2016).

Las ventas de tabletas siguieron bajando aunque tratan de recuperar terreno con mayor poder de procesamiento. Pero los híbridos les quitan terreno.

Los drones repartidores de paquetes ya operan en los Estados Unidos, Gran Bretaña y ahora Francia (Wwwhat's New, 21/12/2016).

2016 fue "el año en que los automóviles que se manejan solos se tomaron las calles". Hasta Uber lanzó taxis sin chofer, pero debió retirarlos porque se saltaban los semáforos en rojo (Wired, 22/12/2016). En España también es ya legal probar coches autónomos (Gizmodo, 23/12/2016). Pero Google abandonó sus proyectos de automóviles autónomos propios y licenciará el software (PCmag, 28/12/2016).

Lo que podría ser una de las grandes pérdidas del año ha sido el proyecto ARA, abandonado por Google. Se proponía fabricar teléfonos móviles modulares que cada uno podría armar según sus preferencias, como Legos (MIT Technology Review, 29/12/2016).

RV y RA

La realidad virtual no ha progresado y la venta de lentes ha sido escasa debido al precio y las escasas aplicaciones. Pero la realidad aumentada parece tener mejores perspectivas, al menos en celulares como ha mostrado el éxito de Pokemon Go y el lanzamiento la plataforma Tango AR de Google para smartphones y de las HoloLens de Microsoft. MagicLeap siguió avanzando y dio a conocer nuevas imágenes, aunque aún no se sabe cuando estará en condiciones de comercializar su producto. Aquí su último video. (NewScientist, 28/12/2016)

El problema está esencialmente en el hardware: la calidad de la experiencia con smartphones deja bastante que desear mientras los Oculus Rift y HTC Vive son caros, pesados, requieren una conexión con un PC con altas prestaciones, y la oferta es casi exclusivamente de videojuegos. En 2016 se vendieron 1,4 millones de dispositivos a nivel mundial, un número pequeño en realidad, que no mejorará hasta que se deje de depender de un PC (Wwwath'sNew, 30/12/2016) ... y se resuelvan los problemas de acomodación visual, especialmente para los mayores de 30 o 40 años, agrego yo.

Científicos desaparecidos

Este año, perdimos a Marvin Lee Minsky (autor de "La sociedad de la mente", foto al lado) y Seymour Papert ("padre" de la corriente de psicología construccionista), su compañero, ambos fundadores del Artificial Intelligence Laboratory en el MIT; Ray Tomlinson, pionero del correo electrónico; y Lloyd S. Shapley, matemático experto en teoría de juegos (que se proyecta en las conductas de colaboración).

(solo pongo los títulos que me parecen más interesantes):

The Ethics of Invention: Technology and the Human Future, by Sheila Jasanoff.

The Signals Are Talking: Why Today’s Fringe Is Tomorrow’s Mainstream, by Amy Webb.

Rise of the Machines: A Cybernetic History, by Thomas Rid.

Chaos Monkeys: Obscene Failure and Random Fortune in Silicon Valley, by Antonio Garcia Martinez.

Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy, by Cathy O’Neil.

Algorithms to Live By: The Computer Science of Human Decisions, by Brian Christian and Tom Griffiths.

The Inevitable: Understanding the 12 Technological Forces That Will Shape Our Future, by Kevin Kelly.

Personaje del año: Elon Musk (FayerWayer, 27/12/2016; MIT Technology Review, 29/12/2016)